La aprobación del AI Act ha provocado una catarata de peticiones sobre aplicaciones en cada país de la Unión Europea y entre estas peticiones está la formulada por una coalición de 17 organizaciones sociales, bajo el nombre de IA Ciudadana, que pide al Gobierno que aplique esta nueva legislación en España con el mayor nivel de protección posible para la ciudadanía.

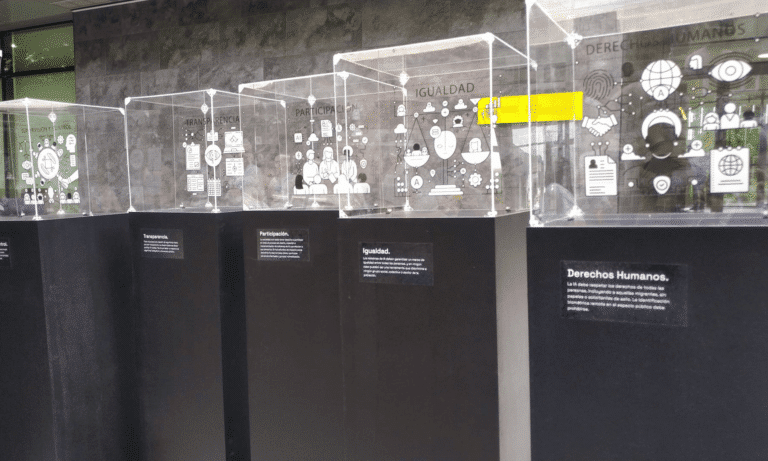

“Transparencia”, “participación”, “igualdad" o “supervisión y control” son algunas de las peticiones clave que desde esta organización reivindica ante el Ministerio para la Transformación Digital y de la Función Pública, liderado por el ministro José Luis Escrivá. Enmarcándolo todo, la petición de una inteligencia artificial

“con más luces que sombras”.

Las peticiones de IA Ciudadana son sencillas y de basan en una inteligencia artificial que tenga "más luces que sombras" y lo plantean en cuatro puntos clave:

1. Prohibir el reconocimiento biométrico en lugares de acceso público, tanto en

tiempo real como a posteriori, y el reconocimiento de emociones en todas sus

formas.

2. Desarrollar un registro de algoritmos y ampliar los supuestos obligatorios en los

que el uso de algoritmos debe registrarse en la base de datos de acceso público que

crea la ley europea, cuyo alcance es limitado.

3. Garantizar un marco de igualdad para todas las personas en los sistemas de IA,

para que no se conviertan en una herramienta que discrimine a ningún sector de la

población.

4. Incorporar la participación efectiva de la sociedad civil en la gobernanza de la

inteligencia artificial y en los estudios de evaluación de impacto sobre los derechos

fundamentales, así como en la definición de políticas públicas de IA.

“El reconocimiento de los rasgos faciales y de las emociones debe ser prohibido sin excepciones, en todos los ámbitos. Es una intromisión innecesaria al derecho a la intimidad y un abuso de poder, que además no tiene evidencia científica y contribuye a la sociedad de la vigilancia" , afirmaba el pasado día 19 de junio Paula Guerra Cáceres, portavoz de la coalición, en un acto ante el ministerio que lidera Escrivá en el que se instalaron unas urnas transparentes con dichas peticiones.

“Además, la sociedad civil, y especialmente los grupos de personas afectadas por el uso de la inteligencia artificial, deben tener derecho a supervisar estos sistemas, a exigir el cese de su uso si se demuestra que estos están reproduciendo discriminaciones y a solicitar reparación para las víctimas”, añadió la portavoz.

Ya se han producido casos como estos, por ejemplo, en los Países Bajos, cuando un algoritmo denegó subvenciones para cuidados infantiles basándose en perfiles raciales, o en Serbia, donde personas con discapacidad no recibieron asistencia social por una automatización del sistema nada inocente. En Reino Unido, una cámara de vigilancia asociada a un sistema de reconocimiento facial identificó erróneamente a un cliente como ladrón reincidente. En España se han implantado también estos sistemas en el ámbito policial y de servicios sociales pero, a pesar de las peticiones de transparencia, no se consigue la información para poder estudiar su impacto.

Por estos motivos, las organizaciones entregaron en el registro del Ministerio una carta en la que piden al ministro Escrivá que cuente con su conocimiento y la experiencia, tanto para la aplicación del AI Act en España, como para el desarrollo de la Agencia Española de Supervisión de la Inteligencia Artificial (AESIA), que sería la encargada de supervisar el cumplimiento de la norma.