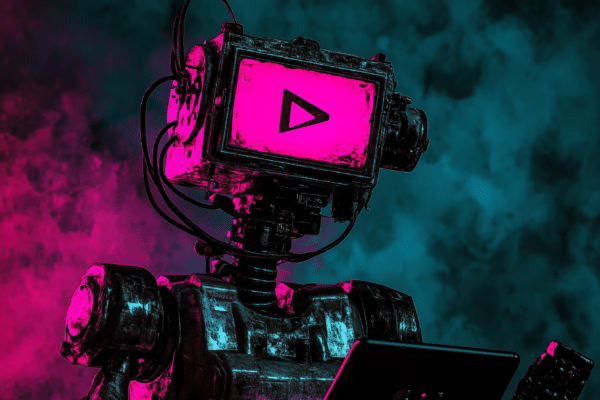

No mundo em rápido desenvolvimento da inteligência artificial, garantir que os sistemas de IA sejam robustos contra resultados tóxicos tornou-se um desafio. Um estudo recente apresenta um novo método chamado Curiosity Driven Network Teaming (CRT), que visa melhorar a detecção e a atenuação de comportamentos indesejáveis em modelos de IA antes de serem implantados.

Os métodos tradicionais de Network Teaming em IA se concentraram principalmente em testar os recursos de tomada de decisão da IA com cenários predefinidos. No entanto, esses métodos geralmente são insuficientes quando se deparam com conteúdo tóxico ou nocivo imprevisível. A abordagem CRT se desvia dessa situação ao incorporar um mecanismo orientado à exploração que procura proativamente possíveis falhas nas respostas da IA, concentrando-se especialmente nas respostas tóxicas.

Toxicidade na IA

A exploração orientada pela curiosidade permite a criação de uma gama diversificada de cenários de teste que refletem interações complexas do mundo real. Ao fazer isso, os modelos de IA são expostos e treinados em um espectro mais amplo de possíveis entradas, incluindo aquelas que podem desencadear respostas indesejadas ou tóxicas. Esse método não apenas identifica as vulnerabilidades existentes, mas também ajuda a ajustar as respostas da IA para que estejam mais alinhadas com as normas éticas e sociais.

As técnicas convencionais de "Red Teaming" geralmente dependem de um conjunto limitado de cenários, que pode não abranger adequadamente as vastas possibilidades de interação entre humanos e IA.

A implementação da CRT envolve o ajuste de vários parâmetros, como amostragem e a adição de um bônus de entropia, que incentiva a geração de casos de teste exclusivos e inovadores. Essa abordagem garante uma avaliação mais abrangente dos comportamentos de IA.

A implementação estratégica da CRT está se mostrando fundamental para o desenvolvimento de sistemas de IA confiáveis e seguros. Ao identificar com eficácia as áreas em que a IA pode apresentar comportamentos tóxicos ou prejudiciais, os desenvolvedores podem refinar os modelos de IA para lidar melhor com esses cenários, aumentando a segurança e a confiabilidade das tecnologias.